Ein Rechenzentrum ist eine Einrichtung, die Server und Netzwerkausrüstung beherbergt, die zum Speichern, Verarbeiten und Verteilen von Daten verwendet wird. Moderne Rechenzentren nutzen Cloud-Architektur und Virtualisierung. Es gibt 4 Standards von Rechenzentren, klassifiziert von Tier 1 bis Tier 4. Es gibt 6 Arten von Rechenzentren: Unternehmens-, Cloud-, Colocation-, Hyperscale-, Edge- und modulare Rechenzentren.

Rechenzentren erfüllen 4 Hauptfunktionen: Netzwerkkonnektivität, Datenspeicherung, Website-Hosting und Backup und Disaster Recovery. Sie ermöglichen Website-Hosting durch das Speichern und Bereitstellen von Website-Dateien über Webserver-Systeme. Kontinuierliche Internetkonnektivität gewährleistet, dass diese Websites online zugänglich bleiben. Router und Switches sind die 2 Schlüsselkomponenten, die Netzwerkverkehr weiterleiten. 4 weitere wesentliche Komponenten sind Server, Verkabelung, Stromversorgung und Kühlsysteme. Rechenzentren verbinden sich mit Internet Service Providern (ISPs) über Edge-Router und Glasfaser, die das Rückgrat des Internets bilden.

Rechenzentren können die Latenz auf 3 Weise verbessern: physische Standortoptimierung, effiziente Routing- und Verkehrsverwaltung und durch die Nutzung von Content Delivery Networks (CDNs). Rechenzentren haben einen wichtigen Einfluss auf die Web-Hosting-Performance. Die Qualität der Infrastruktur eines Rechenzentrums beeinflusst direkt die Server-Betriebszeit. Der Standort eines Rechenzentrums beeinflusst direkt die Geschwindigkeit des Web-Host-Servers. Die Auswahl der besten Rechenzentrumsstandorte für Ihren Web-Host hängt von 3 Schlüsselfaktoren ab: geografische Nähe zu Ihrer Zielgruppe, Rechenzentrumsstandard und lokale Datenschutzbestimmungen.

Inhaltsverzeichnis

- Was ist ein Rechenzentrum?

- Was sind die verschiedenen Arten von Rechenzentren?

- Wofür werden Rechenzentren verwendet?

- Wie ermöglichen Rechenzentren Website-Hosting?

- Welche Netzwerkgeräte ermöglichen es Rechenzentren, Verkehr zu routen?

- Was verbindet Rechenzentren mit ISP?

- Können Rechenzentren die Web-Hosting-Performance beeinflussen?

- Was macht den besten Rechenzentrumsstandort für Web-Hosting aus?

Was ist ein Rechenzentrum?

Ein Rechenzentrum (auch Datacenter genannt) ist eine Einrichtung, die Computing-Ressourcen wie Server, Speichersysteme und Netzwerkausrüstung beherbergt, um Daten zu speichern, zu verarbeiten und zu verteilen. Dies stellt die Infrastruktur bereit und schützt sie, die Websites, Anwendungen und Cloud-Services antreibt.

Rechenzentren gewährleisten kontinuierlichen Betrieb durch Notstromversorgungen, Kühlsysteme und Sicherheitsmaßnahmen. Unternehmen, Regierungen und Service-Provider nutzen zunehmend moderne Rechenzentren, um IT-Arbeitslasten zu verwalten, Online-Plattformen zu hosten und kritische digitale Services zu unterstützen. Rechenzentren befolgen bestimmte Standards, die aus redundanzfokussierten Klassifizierungssystemen wie dem Tier-Modell des Uptime Institute stammen. Diese Standards helfen Unternehmen bei der Auswahl eines Rechenzentrums basierend auf Performance-, Zuverlässigkeits- und Betriebszeitanforderungen.

Was ist ein modernes Rechenzentrum?

Ein modernes Rechenzentrum ist eine Einrichtung, die Cloud Computing und Virtualisierung nutzt, um Skalierbarkeit, Effizienz und Ressourcenverwaltung zu verbessern. Im Gegensatz zu traditionellen Rechenzentren, die auf dedizierte physische Server an einem einzigen Standort angewiesen sind, verteilen moderne Rechenzentren Computing-Ressourcen über mehrere Standorte unter Verwendung von Cloud-Infrastruktur. Dies ermöglicht On-Demand-Zugriff auf Speicher, Verarbeitungsleistung und Anwendungen. Virtualisierung ermöglicht es mehreren virtuellen Maschinen, auf einem einzigen Server zu laufen, wodurch die Hardwareabhängigkeit reduziert und die Ressourcennutzung optimiert wird.

Moderne Rechenzentren nutzen andere Formen von hochmoderner Technologie wie Automatisierung, KI-gesteuerte Sicherheit, biometrische Zugangskontrollen und energieeffiziente Kühlsysteme wie Flüssigkeitskühlung und Heißgang-Einhausung. Diese Fortschritte verbessern die Performance weiter und reduzieren die Betriebskosten.

Was sind die verschiedenen Standards von Rechenzentren?

Es gibt 4 verschiedene Standards von Rechenzentren, klassifiziert vom Uptime Institute als Tier 1 bis Tier 4. Tier-1-Rechenzentren haben grundlegende Infrastruktur ohne Redundanz, Tier 2 fügt Fehlertoleranz mit redundanter Stromversorgung und Kühlung hinzu, Tier 3 bietet hohe Verfügbarkeit mit mehreren redundanten Systemen. Tier 4 bietet die höchste Zuverlässigkeit mit vollständig redundanter, fehlertoleranter Infrastruktur.

Was sind die verschiedenen Arten von Rechenzentren?

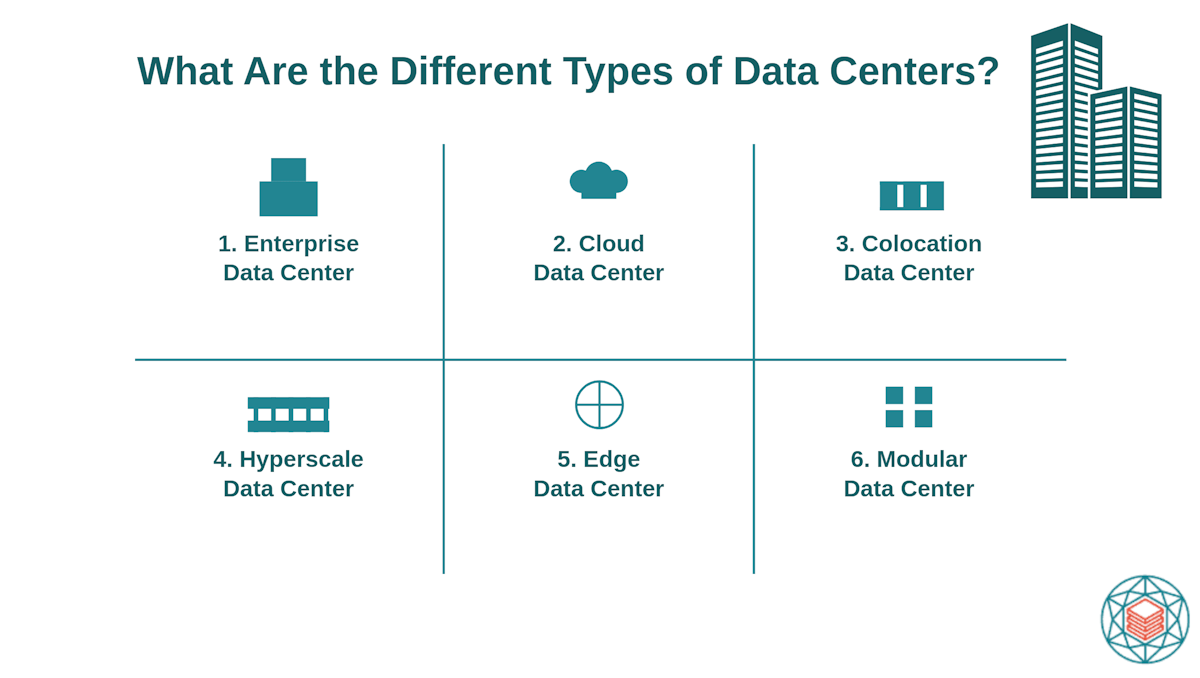

Verschiedene Arten von Rechenzentren beziehen sich auf Unterschiede in ihrem Besitz, Betrieb und ihrer Struktur. Dies ermöglicht es Rechenzentren, eine Reihe von geschäftlichen und technologischen Bedürfnissen zu erfüllen (z.B. private Nutzung, Cloud-Services oder gemeinsame Infrastruktur). Es gibt 6 Arten von Rechenzentren:

- Unternehmensrechenzentrum

- Cloud-Rechenzentrum

- Colocation-Rechenzentrum

- Hyperscale-Rechenzentrum

- Edge-Rechenzentrum

- Modulares Rechenzentrum

1. Unternehmensrechenzentrum

Ein Unternehmensrechenzentrum ist eine privat besessene Einrichtung, die von einer einzigen Organisation gebaut und verwaltet wird, um ihre internen IT-Operationen zu unterstützen. Es bietet dedizierte Ressourcen, vollständige Kontrolle über die Sicherheit und Compliance mit spezifischen Geschäftsanforderungen. Große Unternehmen, Finanzinstitute und Regierungsbehörden nutzen typischerweise Unternehmensrechenzentren.

2. Cloud-Rechenzentrum

Ein Cloud-Rechenzentrum ist eine entfernte Einrichtung, die von Cloud-Service-Providern betrieben wird. Bekannte Cloud-Service-Provider umfassen AWS (Amazon Web Services), Google Cloud und Microsoft Azure. Es bietet skalierbare Computing-Ressourcen auf Abruf, was die Notwendigkeit für Unternehmen eliminiert, physische Serverinfrastruktur zu unterhalten. Cloud-Rechenzentren unterstützen verteilte Arbeitslasten, Disaster Recovery und globale Zugänglichkeit.

3. Colocation-Rechenzentrum

Ein Colocation-Rechenzentrum (auch Multi-Tenant-Rechenzentrum genannt) ist eine gemeinsame Einrichtung, in der Unternehmen Platz für ihre Server und IT-Ausrüstung mieten. Der Provider stellt Strom, Kühlung und Netzwerkkonnektivität bereit, während Kunden die Kontrolle über ihre Hardware behalten. Colocation reduziert Kosten und verbessert die Zuverlässigkeit, ohne dass ein Unternehmen sein eigenes Rechenzentrum bauen muss.

4. Hyperscale-Rechenzentrum

Ein Hyperscale-Rechenzentrum ist eine massive Einrichtung, die für Cloud Computing, Big-Data-Verarbeitung und großmaßstäbliche Anwendungen konzipiert ist. Unternehmen wie Amazon, Google und Meta betreiben Hyperscale-Rechenzentren, um Millionen von Benutzern und Hochleistungsarbeitslasten zu handhaben. Diese Rechenzentren nutzen Automatisierung, fortschrittliche Kühlung und maßgeschneiderte Hardware.

5. Edge-Rechenzentrum

Ein Edge-Rechenzentrum (auch Mikro-Rechenzentrum genannt) ist eine kleine Einrichtung, die sich in der Nähe von Endbenutzern befindet, um die Latenz zu reduzieren. Endbenutzergeräte, IoT-Sensoren und Anwendungen generieren Daten, die die Edge-Zentren lokal filtern, analysieren und optimieren. Diese Zentren handhaben Echtzeitaufgaben, bevor sie nur wesentliche Informationen an größere zentralisierte Rechenzentren wie Unternehmens- oder Hyperscale-Einrichtungen übertragen. Diese Konfiguration reduziert Latenz, verbessert die Performance, minimiert die Bandbreitennutzung und gewährleistet schnelle Antwortzeiten für Anwendungen wie Streaming, Cloud Gaming, autonome Fahrzeuge und das IoT (Internet der Dinge).

6. Modulares Rechenzentrum

Ein modulares Rechenzentrum ist eine vormontierte, eigenständige Einrichtung, die schnell eingesetzt und nach Bedarf skaliert werden kann. Es besteht aus standardisierten, vorgefertigten Modulen (oft in schiffscontainerähnlichen Strukturen untergebracht), die mit eingebauter Stromversorgung, Kühlung und IT-Infrastruktur geliefert werden. Diese modularen Einheiten werden an verschiedene Standorte transportiert und installiert. Sie sind ideal für temporäre Einsätze, Disaster Recovery und abgelegene Gebiete, wo der Bau eines traditionellen Rechenzentrums unpraktisch ist.

Wofür werden Rechenzentren verwendet?

Rechenzentren werden für 4 primäre Funktionen verwendet. Die erste Funktion ist Netzwerkkonnektivität. Rechenzentren fungieren als zentrale Hubs, die Internetverkehr routen. Dies verbindet Unternehmen, Anwendungen und Benutzer über Hochgeschwindigkeits-Glasfasernetzwerke und Netzwerkgeräte wie Router und Switches. Die zweite Funktion ist Datenspeicherung und -verarbeitung. Sie beherbergen leistungsstarke Server, die große Datenmengen für Unternehmen, Regierungen und Cloud-Services speichern, verwalten und verarbeiten.

Die dritte Funktion ist Website-Hosting. Web-Hosting bezieht sich auf einen Web-Service, bei dem ein Provider Einzelpersonen und Unternehmen dabei hilft, ihre Websites ins Internet zu bringen. Die vierte Funktion ist Backup und Disaster Recovery. Unternehmen nutzen Rechenzentren, um Backup-Kopien kritischer Daten zu speichern und Disaster-Recovery-Lösungen zu unterhalten. Dies schützt vor teuren Hardwareausfällen, Cyberangriffen und unerwarteten Ausfällen.

Wie ermöglichen Rechenzentren Website-Hosting?

Rechenzentren ermöglichen Website-Hosting, indem sie die Webserver beherbergen und warten, die Website-Inhalte speichern und bereitstellen. Ein Webserver ist eine Kombination aus Hardware und Software, die Benutzeranfragen verarbeitet und Website-Daten bereitstellt.

Rechenzentren unterstützen Web-Hosting auf 2 Weise. Erstens speichern sie Website-Dateien, einschließlich HTML, CSS, JavaScript, Bilder und Datenbanken, und gewährleisten, dass Daten sicher aufbewahrt werden. Zweitens liefern Rechenzentren Website-Inhalte, indem sie Browser-Anfragen verarbeiten, die notwendigen Dateien abrufen und sie über das Internet an die Geräte der Benutzer übertragen. Web-Hosting-Unternehmen verwalten die Server-Infrastruktur, das Netzwerk und die Software des Rechenzentrums, die für die Website-Bereitstellung benötigt werden.

Wie machen Rechenzentren Websites im Web zugänglich?

Rechenzentren gewährleisten, dass Websites zugänglich bleiben, indem sie kontinuierliche Internetkonnektivität bereitstellen und Ausfallzeiten minimieren. Webserver sind über Hochgeschwindigkeits-Glasfasernetzwerke und Netzwerkgeräte wie Router und Switches mit dem Internet verbunden, die den Datenfluss effizient verwalten. Um die 24/7-Website-Verfügbarkeit zu gewährleisten, nutzen Rechenzentren redundante Stromversorgungen, Kühlsysteme und Sicherheitsmaßnahmen, die Störungen durch Hardwareausfälle, Cyber-Bedrohungen oder Netzwerküberlastung verhindern.

Welche Netzwerkgeräte ermöglichen es Rechenzentren, Verkehr zu routen?

Netzwerkgeräte sind Hardware-Komponenten, die den Datenfluss zwischen Computern, Servern und anderen Systemen innerhalb eines Netzwerks verwalten. Die 2 primären Netzwerkgeräte, die Verkehr routen, sind Router und Switches.

Was ist die Rolle von Routern?

Die Rolle von Routern ist es, den Datenfluss zwischen Netzwerken effektiv zu verwalten. Dies beinhaltet die Bestimmung des effizientesten Pfads für jedes Paket, die Verteilung von Arbeitslasten und die Optimierung der Performance. 2 häufige Arten von Routern sind Edge-Router und Core-Router. Edge-Router verbinden das Rechenzentrum mit einem Internet Service Provider (ISP), um externen Zugang für Websites und Anwendungen zu gewährleisten. Core-Router handhaben Hochgeschwindigkeitsverkehr innerhalb des Rechenzentrums, der verschiedene Netzwerksegmente verbindet.

Was ist der Zweck von Switches?

Der Zweck von Switches ist es, direkte Kommunikation zwischen Geräten innerhalb eines Rechenzentrums zu ermöglichen. Sie verbinden Server, Speichersysteme und andere vernetzte Hardware für schnelle, sichere und effiziente Datenübertragung. Switches arbeiten innerhalb eines lokalen Netzwerks, um Überlastung zu reduzieren und den Datenfluss zu verbessern, im Gegensatz zu Routern, die Verkehr zwischen Netzwerken verwalten.

Was sind die anderen Komponenten eines Rechenzentrums?

Es gibt 4 andere Komponenten eines Rechenzentrums neben Routern und Switches. Die erste Komponente sind Server, die den Kern der Computing-Leistung eines Rechenzentrums bilden. Ein Server verarbeitet und speichert Daten und hostet Anwendungen, Websites und Cloud-Services. Laut IBM beherbergt ein durchschnittliches On-Site-Rechenzentrum zwischen 2.000 – 5.000 Server.

Die zweite Komponente ist die Verkabelung, die Netzwerkgeräte verbindet und Hochgeschwindigkeitskommunikation zwischen Servern und externen Netzwerken gewährleistet. Die dritte Komponente sind Stromsysteme, die den Betrieb auch während elektrischer Ausfälle aufrechterhalten. Dies umfasst Backup-Generatoren und unterbrechungsfreie Stromversorgungen (USV). Die vierte Komponente sind Kühlsysteme, die die Rechenzentrumstemperatur regulieren und Überhitzung verhindern.

Was verbindet Rechenzentren mit ISP?

Ein Internet Service Provider (ISP) ist ein Unternehmen, das Internetzugang für Unternehmen und Einzelpersonen bereitstellt. Rechenzentren sind über Edge-Router und Hochgeschwindigkeits-Glasfasernetzwerke mit ISPs verbunden. Edge-Router dienen als Gateway zwischen dem internen Netzwerk eines Rechenzentrums und dem ISP und leiten ein- und ausgehenden Internetverkehr weiter. Hochgeschwindigkeits-Glasfaserkabel transportieren Daten über große Entfernungen mit minimaler Verzögerung für schnelle und zuverlässige Konnektivität. Zusammen bilden Rechenzentren und ISPs das Rückgrat des Internets.

Wie können Rechenzentren die Netzwerklatenz verbessern?

Netzwerklatenz bezieht sich auf die Zeit, die Daten benötigen, um zwischen einer Quelle und einem Ziel über ein Netzwerk zu reisen. Die Verbesserung der Latenz bezieht sich auf die Reduzierung dieser Zeit. Rechenzentren können die Netzwerklatenz auf 3 Weise verbessern.

Der erste Weg ist die physische Standortoptimierung, die Rechenzentren näher zu den Benutzern platziert. Dies verkürzt die Entfernung, die Daten zurücklegen müssen, und verbessert dadurch die Server-Antwortzeiten. Der zweite Weg ist effizientes Routing und Verkehrsmanagement. Dies bedeutet die Verwendung fortschrittlicher Netzwerkprotokolle und Load Balancing, um Verkehrsüberlastung zu verhindern. Der dritte Weg ist die Nutzung von Content Delivery Networks (CDNs). Dieses System speichert zwischengespeicherte Kopien von Website-Inhalten an mehreren Standorten und ermöglicht es Benutzern, auf Daten von einem näheren Server zuzugreifen.

Können Rechenzentren die Web-Hosting-Performance beeinflussen?

Ja, Rechenzentren können die Web-Hosting-Performance beeinflussen. Web-Hosting-Performance wird am besten durch 2 Indikatoren verstanden: Server-Betriebszeit und Server-Geschwindigkeit. Server-Betriebszeit bezieht sich auf den Prozentsatz der Zeit, in der der Host-Server ohne Unterbrechungen vollständig betriebsbereit bleibt. Server-Geschwindigkeit bezieht sich auf die Zeit, die der Host-Server benötigt, um auf Anfragen zu antworten. Dies ist auch als Server-Antwortzeit bekannt und wird in Millisekunden (ms) gemessen. Beide Metriken kombiniert bieten einen guten Indikator für einen qualitativ hochwertigen Web-Host-Service.

Die Web-Hosting-Server-Betriebszeit wird direkt von der Infrastruktur des Rechenzentrums beeinflusst. Die Web-Hosting-Server-Geschwindigkeit wird direkt vom Standort des Rechenzentrums beeinflusst.

Wie beeinflusst die Rechenzentrumsinfrastruktur die Web-Hosting-Performance?

Die Rechenzentrumsinfrastruktur beeinflusst die Web-Hosting-Performance, indem sie die Zuverlässigkeit der Server bestimmt und damit direkt die Betriebszeit der gehosteten Websites und Anwendungen ihrer Kunden beeinflusst.

Schätzungen der Betriebszeit nach Rechenzentrum-Tier sind in einem offiziellen Whitepaper von 2008 des Uptime Institute mit dem Titel „Tier Classifications Define Site Infrastructure Performance“ dargelegt. Laut dem Bericht erwarten Tier-1-Rechenzentren eine Betriebszeit von 99,67% und etwa 28,8 Stunden Ausfallzeit pro Jahr. Tier-2-Rechenzentren haben eine Betriebszeit von 99,75% und reduzieren die jährliche Ausfallzeit auf etwa 22 Stunden. Tier-3-Rechenzentren haben 99,98% Betriebszeit und begrenzen die Ausfallzeit auf etwa 1,6 Stunden pro Jahr. Tier-4-Rechenzentren haben 99,99% Betriebszeit und nur 0,8 Stunden Ausfallzeit jährlich. Höhere Tier-Rechenzentren ermöglichen es Web-Hosts, stärkere Betriebszeitgarantien für Kunden zu bieten.

Wie beeinflusst der Rechenzentrumsstandort die Web-Hosting-Performance?

Der Rechenzentrumsstandort beeinflusst die Web-Hosting-Performance aufgrund des Latenz-Effekts. Größere physische Entfernung zwischen dem Rechenzentrum und den Endbenutzern verursacht längere Verzögerungen bei der Datenbereitstellung.

Der Rechenzentrumsstandort ist wichtig, weil er die Server-Nähe relativ zu 2 Dingen bestimmt: Website-Besucher und wichtige Internet-Austauschpunkte (IXPs).

Im Web-Hosting führt hohe Latenz zwischen dem Webserver und Website-Besuchern zu langsamen Server-Antwortzeiten und trägen Website-Ladezeiten. Hosting von einem Rechenzentrumsstandort in der Nähe von Website-Besuchern verbessert Antwortzeiten und Site-Geschwindigkeit.

Die Nähe zu wichtigen Internet-Austauschpunkten (IXPs) verbessert die Performance weiter, indem sie Netzwerk-Hops zwischen dem Server und den Endbenutzern reduziert.

Was macht den besten Rechenzentrumsstandort für Web-Hosting aus?

Der beste Rechenzentrumsstandort für Web-Hosting berücksichtigt 3 Dinge. Der erste Faktor ist die enge Nähe zur Zielgruppe Ihrer Website. Der zweite ist ein hoher Rechenzentrumsstandard, der Tier 3 oder Tier 4 ist. Der dritte ist eine Ebene der Datenschutz-Compliance, die Ihre besonderen geschäftlichen oder branchenspezifischen Bedürfnisse erfüllt. Datenschutz-Compliance (PIPEDA, DSGVO, HIPAA) wird typischerweise durch die Gerichtsbarkeit des Rechenzentrumsstandorts bestimmt. Die Auswahl des besten Serverstandorts hängt letztendlich vom Typ und den Prioritäten Ihrer Website ab. Compliance ist kritischer für Sites, die sensible Daten verarbeiten, während Zielgruppennähe kritischer für E-Commerce-Sites ist, die Geschwindigkeit benötigen.